A Meta divulgou o Frontier AI Framework, um documento detalhando sua abordagem para o desenvolvimento de inteligência artificial avançada. A empresa afirma que não construirá sistemas que apresentem risco crítico, aqueles que poderiam viabilizar cenários catastróficos sem possibilidade de mitigação.

Para isso, a Meta classifica modelos de IA em três níveis de risco: crítico, alto e moderado. A categorização considera o potencial de cada tecnologia para permitir ameaças significativas.

Diferentemente dos níveis alto e moderado, o risco crítico significa que a IA poderia viabilizar, de forma única, cenários catastróficos, como o desenvolvimento de armas biológicas ou ataques cibernéticos de larga escala. Segundo a empresa, tais sistemas não serão desenvolvidos.

Modelos de risco alto serão restritos; moderados terão segurança variável

Os sistemas de alto risco poderão ser desenvolvidos, mas não lançados ao público. A Meta afirma que esses modelos terão acesso restrito a equipes de pesquisa e contarão com medidas de segurança contra infiltração hacker.

Já os de risco moderado poderão ser implementados, com medidas de segurança ajustadas conforme a estratégia de lançamento. Esses modelos não apresentariam ameaças significativas, segundo o documento.

A Meta também reconhece que o desenvolvimento da IA envolve múltiplos fatores externos, além do próprio modelo tecnológico. O relatório destaca que há divergências internas entre especialistas da empresa sobre a velocidade e a forma como essas capacidades irão evoluir.

Com essa iniciativa, a Meta busca definir um padrão para avaliar riscos na construção de sistemas de IA avançados. A abordagem, no entanto, não conta com validação externa, pois a estrutura foi criada pelos próprios especialistas da companhia.

-

![]()

1/7 (O MIT Computer Science and Artificial Intelligence Laboratory (CSAIL), em Cambridge, Massachusetts, desenvolveu o sistema de diagnóstico de câncer de mama baseado em IA, reduzindo erros em 15%.)

-

![]()

2/7 (O Google AI, com sede em Mountain View, Califórnia, criou o AlphaGo, o primeiro programa de IA a derrotar um campeão mundial de Go, revolucionando a pesquisa em aprendizado profundo.)

-

![Localizado em Londres, Reino Unido, o DeepMind Lab é famoso pelo desenvolvimento do AlphaFold, um programa de IA que previu estruturas de proteínas com precisão sem precedentes, impactando a biologia molecular. Localizado em Londres, Reino Unido, o DeepMind Lab é famoso pelo desenvolvimento do AlphaFold, um programa de IA que previu estruturas de proteínas com precisão sem precedentes, impactando a biologia molecular.]()

3/7 Localizado em Londres, Reino Unido, o DeepMind Lab é famoso pelo desenvolvimento do AlphaFold, um programa de IA que previu estruturas de proteínas com precisão sem precedentes, impactando a biologia molecular. (Localizado em Londres, Reino Unido, o DeepMind Lab é famoso pelo desenvolvimento do AlphaFold, um programa de IA que previu estruturas de proteínas com precisão sem precedentes, impactando a biologia molecular.)

-

![]()

4/7 (O IBM Watson Research Center, em Yorktown Heights, Nova York, desenvolveu a IA Watson, que venceu campeões humanos no programa de TV Jeopardy!, demonstrando avanços significativos em processamento de linguagem natural.)

-

![]()

5/7 (O Baidu Research Lab, em Pequim, China, é conhecido por seu sistema de reconhecimento de voz Deep Speech, que alcançou uma precisão de 97% na transcrição de áudio, superando as tecnologias anteriores.)

-

![]()

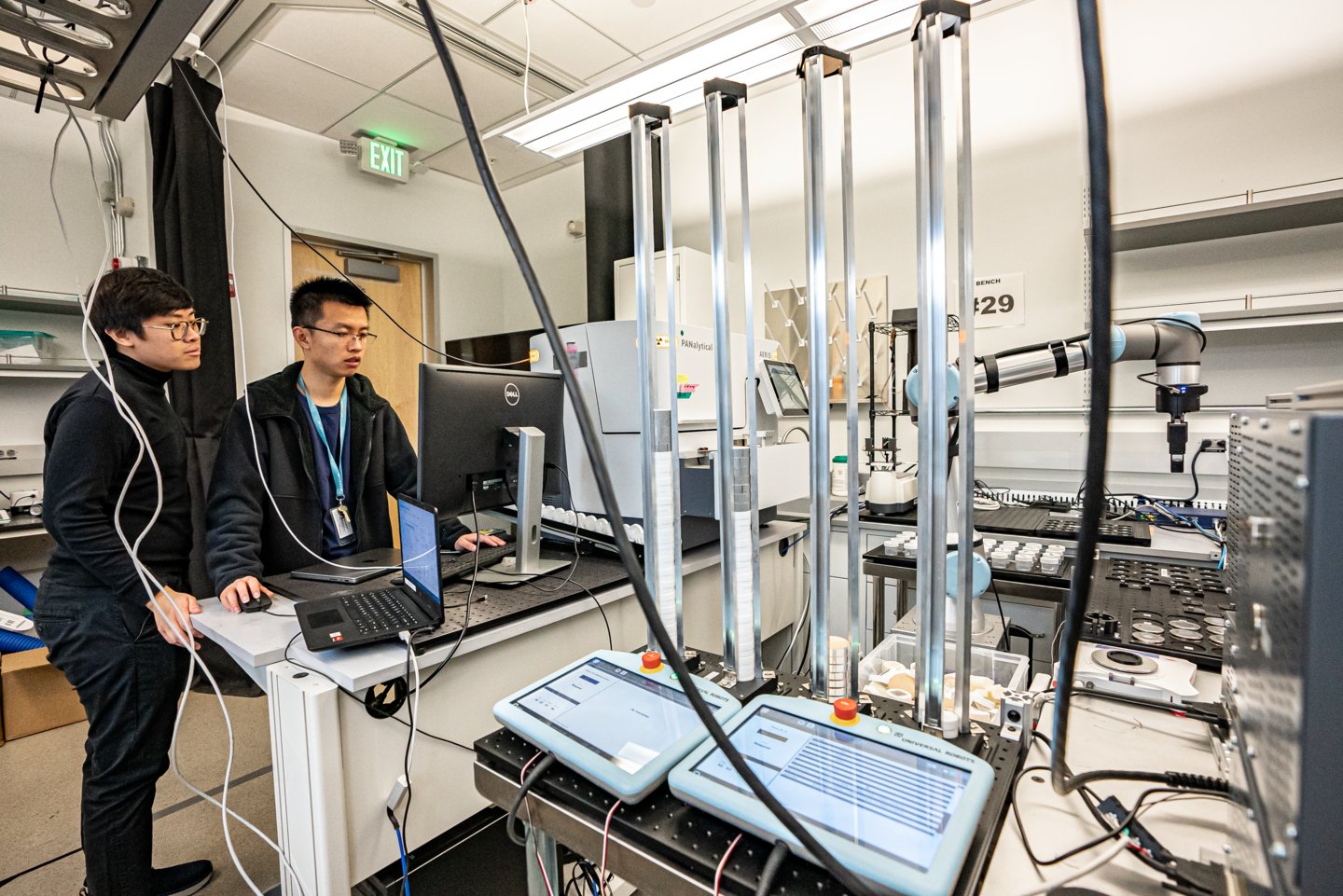

6/7 (O Berkeley Artificial Intelligence Research (BAIR) Lab, na Universidade da Califórnia, em Berkeley, criou algoritmos avançados de robótica, incluindo o Dex-Net, que melhorou a precisão da manipulação robótica em 99%.)

-

![]()

7/7 (O centro da Meta AI Research SuperCluster (RSC) tem um dos supercomputadores de IA mais rápidos da atualidade. Com ele, a empresa desenvolveu o sistema de tradução automática baseado em IA que suporta mais de 100 idiomas, melhorando a comunicação global em plataformas sociais da empresa.)

:format(webp))