Claude pode criar respostas que tem o intuito concordar com o usuário, diz pesquisa da Anthropic

A empresa se inspirou na neurociência e construiu um microscópio para entender como LLMs criam estratégias e raciocinam para chegar até suas respostas

Redatora

Publicado em 28 de março de 2025 às 10h41.

A Anthropic, dona do Claude, avançou alguns passos na compreensão do que acontece com os grandes modelos de linguagem (LLMs) quando respondem a comandos e perguntas. A startup descobriu, inclusive, que a inteligência artificial, pode criar raciocínios falsos para responder perguntas de forma favorável ao usuário.

Os LLMs não são programados por seres humanos, e sim treinados por eles com base em grandes quantidades de dados. Durante esse treinamento, eles apresentem suas próprias estratégias para resolver problemas, mas seres humanos não têm acesso a isso, o que significa que, mesmo os criadores da IA não entendem como os modelos fazem a maior parte das atividades. Isso gera incerteza para sua aplicação por alguns negócios.

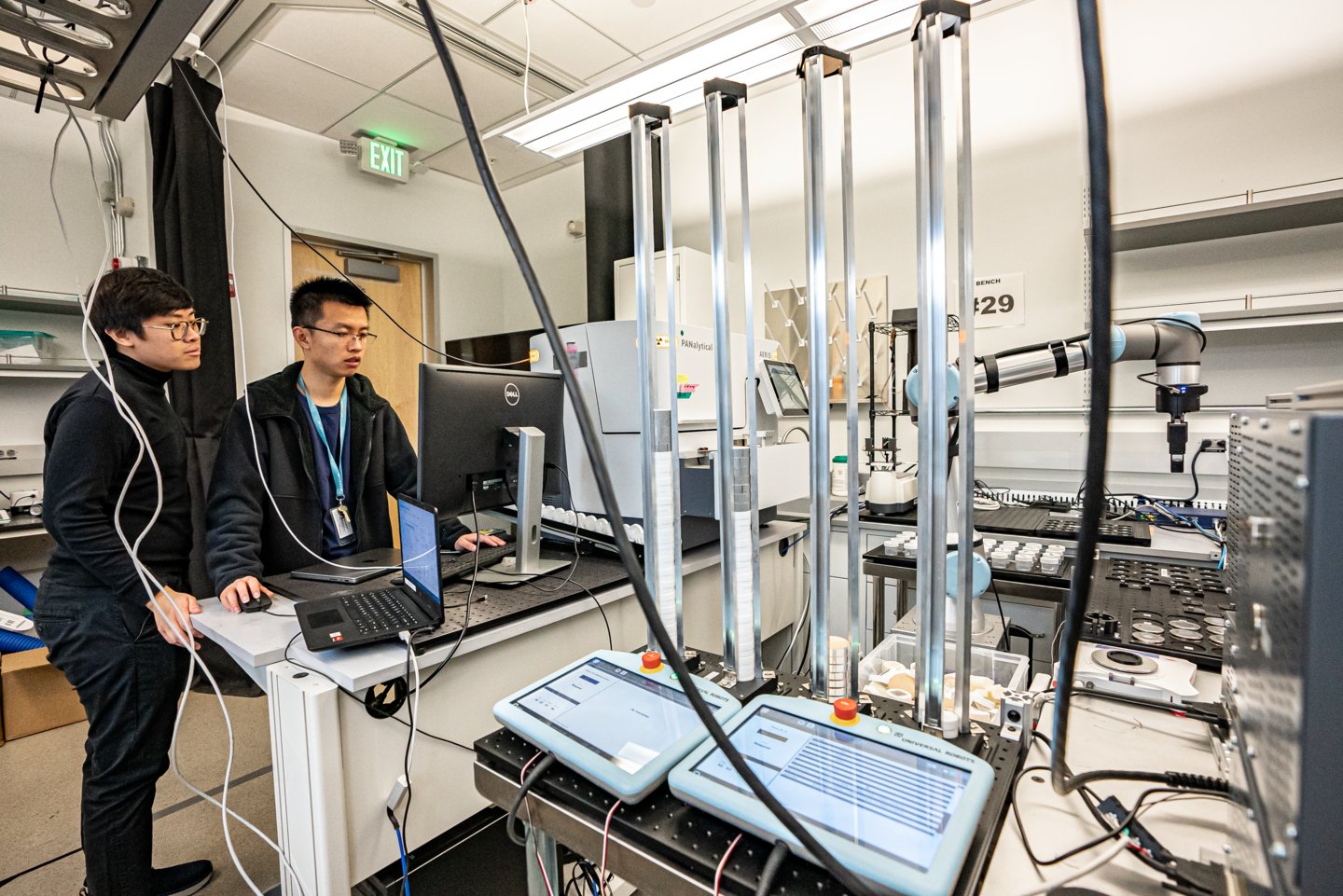

A Anthropic se inspirou na neurociência e construiu um tipo de microscópio para avaliar IAs se inspirando na neurociência. A ideia é tentar identificar padrões e fluxos de informação dos LLMs. Com isso, a empresa trouxe pistas para parte do que acontece quando o Claude responde a perguntas de usuários.

Pesquisadores encontraram evidências de que o Claude pode dar um argumento que soa plausível mas que foi feito para concordar com o usuário, em vez de seguir passos lógicos. A Anthropic observou que, ao ser perguntado sobre uma difícil questão de matemática e ter recebido uma dica falsa, o Claude fez um raciocínio falso.

Outro ponto trazido pela pesquisa da Anthropic é que o Claude, às vezes, pensa em um espaço conceitual entre idiomas, o que sugere que o LLM tem uma espécie de “linguagem de pensamento” universal. Os pesquisadores chegaram até essa hipótese ao traduzir frases simples para vários idiomas e rastrear a sobreposição na maneira como o Claude as processa.

Além disso, o Claude planeja o que irá dizer muitas palavras à frente. A Anthropic demonstrou isso ao pedir que o Claude fizesse um poema. A IA antecipava possíveis palavras que rimam e escrevia a próxima linha para alcançá-la, o que demonstra que ela pode pensar em horizontes mais longos, apesar de ter sido treinada para gerar uma palavra por vez.

Ainda assim, a empresa reconhece as limitações dos estudos, que capturou apenas uma fração do total de computação performada por Claude. Os resultados foram publicados em dois artigos: o primeiro ligou conceitos dentro de um modelo a circuitos computacionais para revelar o caminho entre as palavras que entram no Claude e as que saem e o segundo observou como o Claude 3.5 Haiku fazia estudos profundos de tarefas simples.