Um contexto sobre as Notas da Comunidade do Twitter

Entendendo o controverso método da plataforma para combater desinformação

PARIS, FRANCE - APRIL 26: In this photo illustration, the Twitter app logo is displayed on the screen of an iPhone on April 26, 2022 in Paris, France. The U.S. multi-billionaire Elon Musk bought the social network Twitter on Monday April 25 for the sum of 44 billion dollars after two weeks of arm wrestling with the company's board of directors. (Photo illustration by Chesnot/Getty Images) (Chesnot/Getty Images)

Colunista - Instituto Millenium

Publicado em 7 de dezembro de 2023 às 13h01.

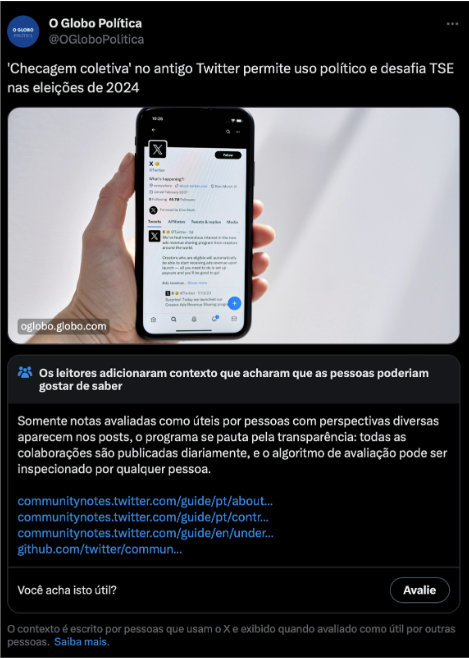

Uma reportagem publicada por O Globo chamou a atenção para o perigo potencial do novo mecanismo de combate à desinformação do antigo Twitter (agora X), as chamadas Notas da Comunidade. A ferramenta permite que os usuários da plataforma adicionem um texto que contextualiza os tuítes publicados por outros, quando considerarem as informações enganosas. Rapidamente, a própria reportagem d'O Globo recebeu Notas de Comunidade:

A mensagem que aparece abaixo do tuíte com a reportagem, sob o título "Os leitores adicionaram contexto que acharam que as pessoas poderiam gostar de saber", é uma das Notas da Comunidade. Como todas elas, foi escrita por um usuário anônimo e votada como "útil" por diversos usuários pela plataforma. E como todas, é limitada em tamanho e, consequentemente, em quanto consegue informar os usuários. Felizmente, essa coluna tem mais espaço para corrigir e esclarecer a reportagem.

A matéria levanta uma questão pertinente: como um sistema colaborativo, escrito e avaliado por usuários anônimos, pode ser uma ferramenta de combate à desinformação? Como evitar o uso político por grupos organizados?

São essas perguntas que a iniciativa Birdwatch, anunciada pelo Twitter em janeiro de 2021 — muito antes da aquisição da empresa por Elon Musk — queria responder. O algoritmo criado para essa missão foi descrito em um estudo publicado em outubro do ano passado, disponível abertamente na internet.

Desde lá, o algoritmo foi se sofisticando e adquirindo modificações até virar o que hoje conhecemos como Notas da Comunidade, mas é possível descrever seu mecanismo em linhas gerais. Primeiro, apenas usuários que usam o Twitter há mais de seis meses, não violaram nenhuma regra da plataforma e têm um telefone verificado podem se inscrever para participar. Uma vez aprovados, esses usuários podem escrever notas adicionando contexto aos tuítes que lerem na plataforma e avaliar as notas produzidas por outras pessoas de acordo com o nível de utilidade que atribuem à nota.

A verdadeira engenhosidade do sistema está em como usar essas avaliações feitas por usuários para determinar quais notas devem aparecer na plataforma para que qualquer um possa ver. Em vez de adotar um simples sistema de votação, que tornaria o sistema vulnerável a ataques organizados, os pesquisadores do Twitter desenvolveram um algoritmo que avalia cada nota não só por quão útil os usuários as consideram, mas também por sua "polaridade". Pouparei o leitor da matemática envolvida, mas o que é importante entender é que esse parâmetro permite identificar notas que apelam a apenas um determinado grupo ideológico e reduzir o nível de utilidade que elas acabam recebendo. Assim, notas que são consideradas úteis por usuários que tendem a discordar entre si e a ter opiniões opostas recebem avaliações melhores na plataforma.

O sistema empregado é um algoritmo de aprendizado de máquina (a base da inteligência artificial moderna) que classifica não só as notas mas também os usuários de acordo com suas visões. Notas contendo opiniões políticas associadas à esquerda são avaliadas como opostas a notas contendo opiniões associadas à direita. Dessa forma, para que uma nota seja promovida, ela precisa ser votada como útil tanto por pessoas de esquerda como de direita. As Notas da Comunidade são, assim, um instrumento não só de combate à desinformação mas também de combate à polarização, com notas verdadeiras mas polarizantes recebendo avaliações piores.

É interessante notar que a divisão entre esquerda e direita não foi "ensinada" diretamente ao sistema, mas algo que ele identificou ao observar como usuários diferentes avaliavam notas diferentes, o que permite ao modelo capturar sutilezas da polarização política. (Curiosamente, uma quantidade surpreendente das notas identificadas pelo sistema como de "direita" são discussões de política em português brasileiro.)

Esse foi um dos pontos que a nota adicionada à reportagem d'O Globo procurou corrigir: a ferramenta minimiza o risco de uso político ao incorporar a polarização dos avaliadores como critério de quais notas vão ao ar.

A reportagem cita esse processo, mas os especialistas ouvidos o descrevem como misterioso e pouco transparente. Tai Nalon, diretora e cofundadora do site de checagem de fatos Aos Fatos, é citada alegando que "A gente não sabe se grupos políticos podem organizar uma publicação e a aprovação das notas. A gente não sabe como é balanceado o algoritmo, quantos votos são necessários para que uma nota entre e saia do ar".

No entanto, o código das Notas da Comunidade é open source, o que significa que qualquer pessoa (com o devido conhecimento técnico) pode ler como ele funciona e até mesmo baixar e rodar o programa em seu computador, e pode ser acessado aqui. O modelo usa técnicas relativamente simples e conhecidas dentro do universo da inteligência artificial, como o gradiente descendente e o método de mínimos quadrados. Além disso, o Twitter tem um manual descrevendo em detalhes como o algoritmo funciona, além de disponibilizar publicamente todos os dados de todas as notas sugeridas e avaliações atribuídas. Isso permite que programadores independentes verifiquem como o algoritmo funciona, auditem por que determinadas notas estão sendo promovidas ou removidas e até mesmo testem o sistema contra ataques.

Outra pesquisadora ouvida por O Globo, Iná Jost, enfatiza que o Twitter cobra pelo acesso a dados, criticando a falta de transparência. Essa afirmação também é enganosa, visto que, embora seja verdade que o Twitter cobra pelo acesso a alguns dados da plataforma, isso não se aplica aos dados das Notas de Comunidade, que como indicado acima podem ser baixados gratuitamente todos os dias.

Isso não significa que o sistema seja isento de críticas, é claro. Yoel Roth, que comandava a divisão de Confiança e Segurança do Twitter antes da entrada de Elon Musk, critica a administração atual por ter abandonado a estratégia dupla de moderação: inicialmente, as notas tinham o objetivo de ser um complemento à moderação tradicional e centralizada, mas passaram a ser o principal mecanismo de combate à desinformação do Twitter de Musk.

As notas também não são imunes a vieses da comunidade. Embora o sistema considere a polarização dos usuários, se todos os usuários tiverem um mesmo viés, ele será refletido nas notas.

Além disso, sistemas de inteligência artificial tem limitações quanto à inteligibilidade do que está acontecendo. Embora o código das Notas da Comunidade seja aberto, é necessário conhecimento aprofundado para entender o sistema, e mesmo para especialistas o modelo não é completamente previsível. O programador e criptoativista Vitalik Buterin, por exemplo, aponta como problema a complexidade excessiva do algoritmo, que dificulta a auditoria. Executando o programa em seu computador, ele foi capaz de verificar que não houve interferência do Twitter em uma nota crítica ao governo chinês que estava publicada e foi tirada do ar, mas não foi capaz de dizer por que exatamente o algoritmo passou a considerar aquela nota como menos útil.

Ainda assim, Buterin é bastante entusiasta do instrumento, o descrevendo como um "experimento fascinante" e "impressionantemente útil". Ele destaca que o sistema chega muito próximo ao que ele chama de "o ideal da neutralidade crível": a característica de um desenho institucional de ser facilmente percebido como imparcial ao ser observado.

O que quer que se pense sobre o sujeito hoje dono do Twitter, o instrumento — que nasceu antes dele surgir em cena — é uma ferramenta poderosa contra a qual nem ele está protegido: os tuítes de Musk e até mesmo propagandas dentro da plataforma têm constantemente recebido Notas da Comunidade os classificando como enganosos.

No fim das contas, qualquer mecanismo de verificação de informações terá suas ressalvas e limitações. As falhas na reportagem d'O Globo só mostram como mesmo os instrumentos empregados pelos grandes veículos de mídia, como recorrer a especialistas, são falhos. (Como é padrão entre os grandes jornais, a reportagem não disponibiliza referências externas que não as pesquisadoras entrevistadas, nem mesmo links.) Não significa que devemos descredibilizá-los completamente — em geral, quem usa esses casos para enaltecer mídias alternativas em detrimento dos grandes veículos não o faz por interesse no combate à desinformação e sim por birra ideológica. Mas se queremos efetivamente avançar em direção a um debate público menos pautado em desinformação e polarização, precisamos favorecer e estimular mecanismos engenhosos como as Notas da Comunidade.

Em tempos de cacofonia de opiniões na internet, é difícil imaginar que haja uma forma de combater a disseminação de informações falsas que não esteja sujeita a críticas de imprecisão ou cooptação por interesses políticos. Talvez o próprio ideal de um sistema que possa identificar informações verdadeiras e incontestáveis nem faça sentido dado o que entendemos sobre o processo científico hoje em dia. As Notas da Comunidade, no entanto, são um passo importante em direção a uma verificação de informações mais consensual ao longo do espectro político, com um desenho sofisticado para evitar os perigos da polarização.

:format(webp))